58 TECHNIQUES DE PROMPTING BASEES SUR LE TEXTE

Résumé de section

-

-

Nous mettons en avant six principales décisions de conception lors de la création de prompts avec quelques exemples. *Veuillez noter que les recommandations présentées ici ne s'appliquent pas à toutes les tâches. Dans certains cas, elles peuvent nuire aux performances.

-

Sélectionner des exemples (exemplars) pour un prompt est une tâche complexe. Les performances du modèle dépendent fortement de plusieurs facteurs liés aux exemples choisis (Dong et al., 2023), d’autant plus que la fenêtre de contexte des modèles linguistiques (LLMs) ne permet de traiter qu’un nombre limité d’exemples. Nous mettons en avant six décisions de conception majeures, incluant la sélection et l’ordre des exemples, qui influencent de manière critique la qualité des sorties (Zhao et al., 2021a ; Lu et al., 2021 ; Ye et Durrett, 2023) (Figure 2.3).

-

En prenant en compte tous ces facteurs, le prompting avec quelques exemples (Few-Shot Prompting) peut s’avérer complexe à mettre en œuvre efficacement. Nous examinons ici des techniques spécifiques à ce type de prompting dans un cadre supervisé. Les approches d’ensemble (ensembling) peuvent également être bénéfiques, mais elles sont abordées séparément.

-

Contrairement à la suggestion par quelques exemples (Few-Shot Prompting), la suggestion zéro-exemple (Zero-Shot Prompting) n'utilise aucun exemple. Il existe plusieurs techniques zéro-exemple bien connues, utilisées soit seules, soit combinées avec un autre concept (par exemple, Chain of Thought), que nous discutons plus tard

-

La génération de pensée englobe un ensemble de techniques qui incitent le LLM à exprimer son raisonnement tout en résolvant un problème (Zhang et al., 2023c).

-

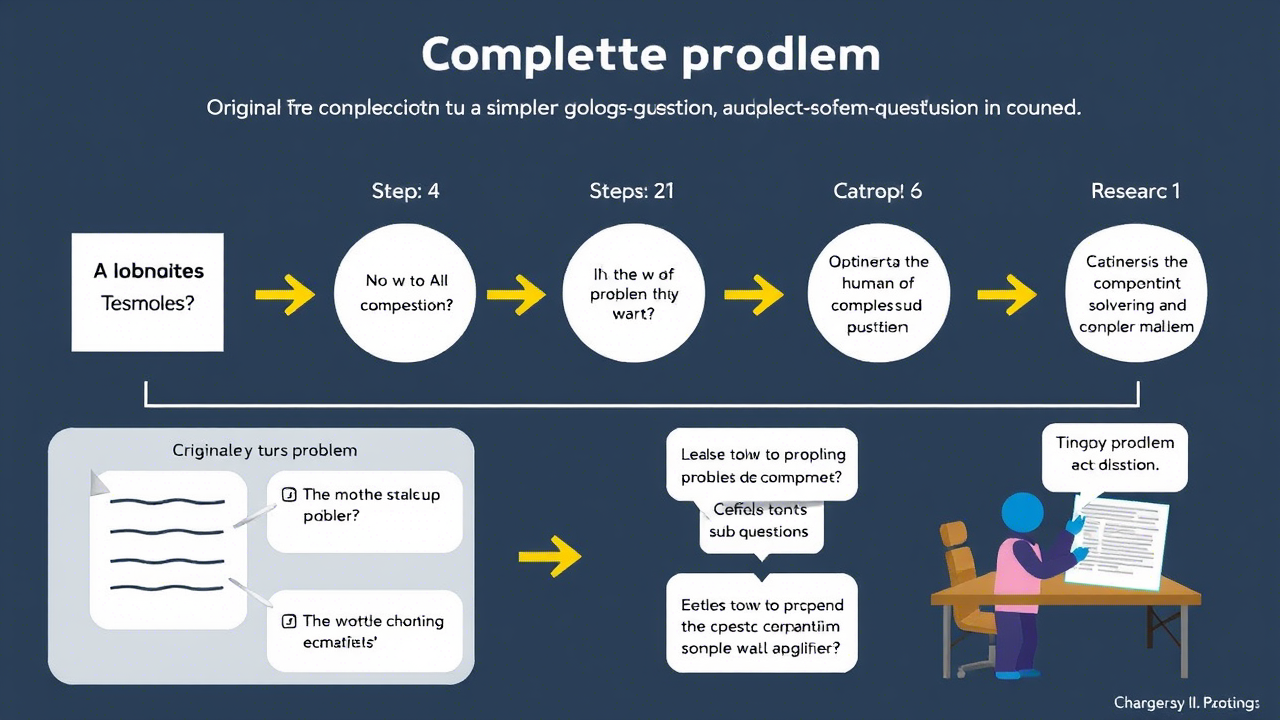

Une importante recherche s'est concentrée sur la décomposition de problèmes complexes en sous-questions plus simples. Il s'agit d'une stratégie efficace de résolution de problèmes, tant pour les humains que pour les IA génératives (Patel et al., 2022). Certaines techniques de décomposition sont similaires aux techniques d'induction de pensée, comme CoT (Chaîne de Pensée), qui décompose souvent naturellement les problèmes en composantes plus simples. Cependant, la décomposition explicite des problèmes peut encore améliorer davantage la capacité de résolution de problèmes des LLMs.

-

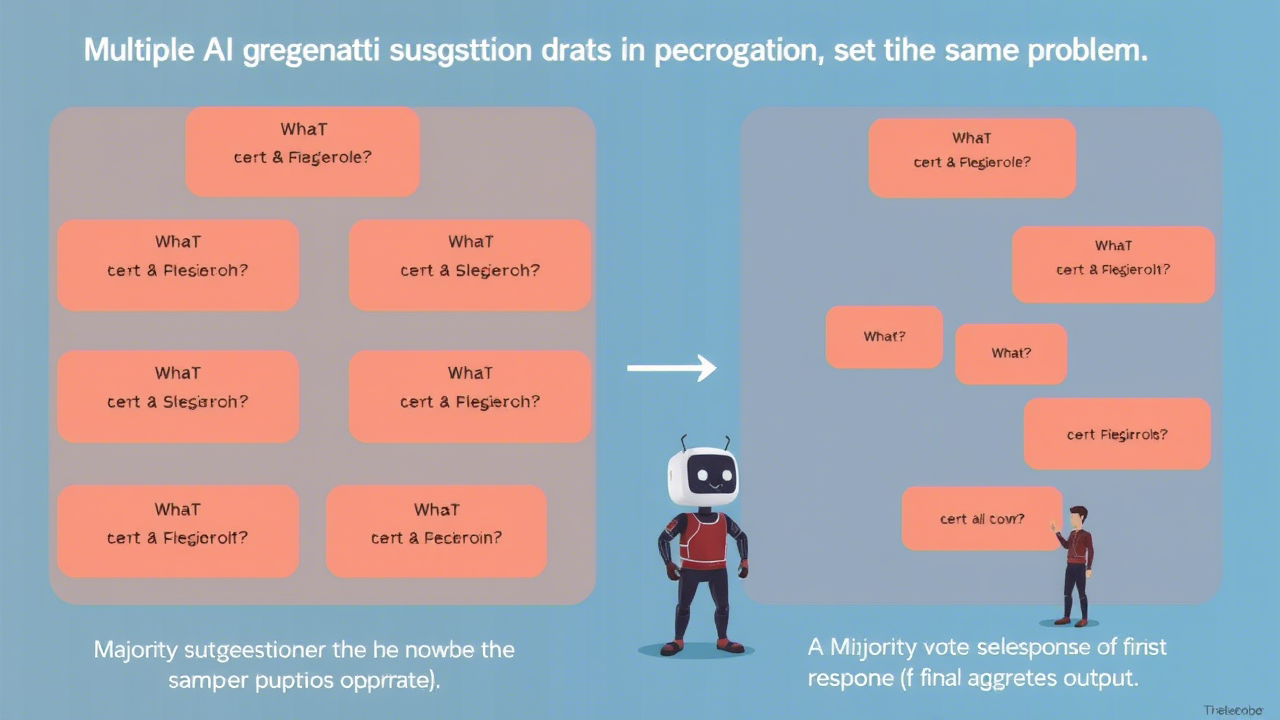

Dans le domaine de l'IA générative, le regroupement consiste à utiliser plusieurs suggestions pour résoudre le même problème, puis à agréger ces réponses en une sortie finale. Dans de nombreux cas, un vote majoritaire – en sélectionnant la réponse la plus fréquente – est utilisé pour générer la sortie finale. Les techniques de regroupement réduisent la variance des sorties des LLMs et améliorent souvent l'exactitude, mais augmentent également le nombre d'appels au modèle nécessaires pour obtenir une réponse finale.

-

Lors de la création de systèmes d'IA générative, il peut être utile que les LLMs critiquent leurs propres sorties (Huang et al., 2022). Cela peut simplement être un jugement (par exemple, cette sortie est-elle correcte ?) ou le LLM peut être incité à fournir des commentaires qui seront ensuite utilisés pour améliorer la réponse. De nombreuses approches ont été développées pour générer et intégrer l'auto-critique. -

Les 25 meilleurs articles de notre ensemble de données, mesurés par leur nombre de citations par d'autres articles dans notre ensemble de données. La majorité des articles ici présentent des techniques de suggestion*, et les articles restants contiennent des conseils sur la suggestion.

-

Outre l'examen des techniques de suggestion, nous passons également en revue les techniques de génie des suggestions, qui sont utilisées pour optimiser automatiquement les suggestions. Nous discutons de certaines techniques qui utilisent des mises à jour par gradient, car l'ensemble des techniques de génie des suggestions est bien plus restreint que celui des techniques de suggestion.

-

Le génie des réponses est le processus itératif consistant à développer ou sélectionner des algorithmes qui extraisent des réponses précises à partir des sorties des LLMs. Pour comprendre la nécessité du génie des réponses, considérons une tâche de classification binaire où les étiquettes sont "Discours de Haine" et "Pas de Discours de Haine".

-