Techniques de Suggestion Zéro-Exemple

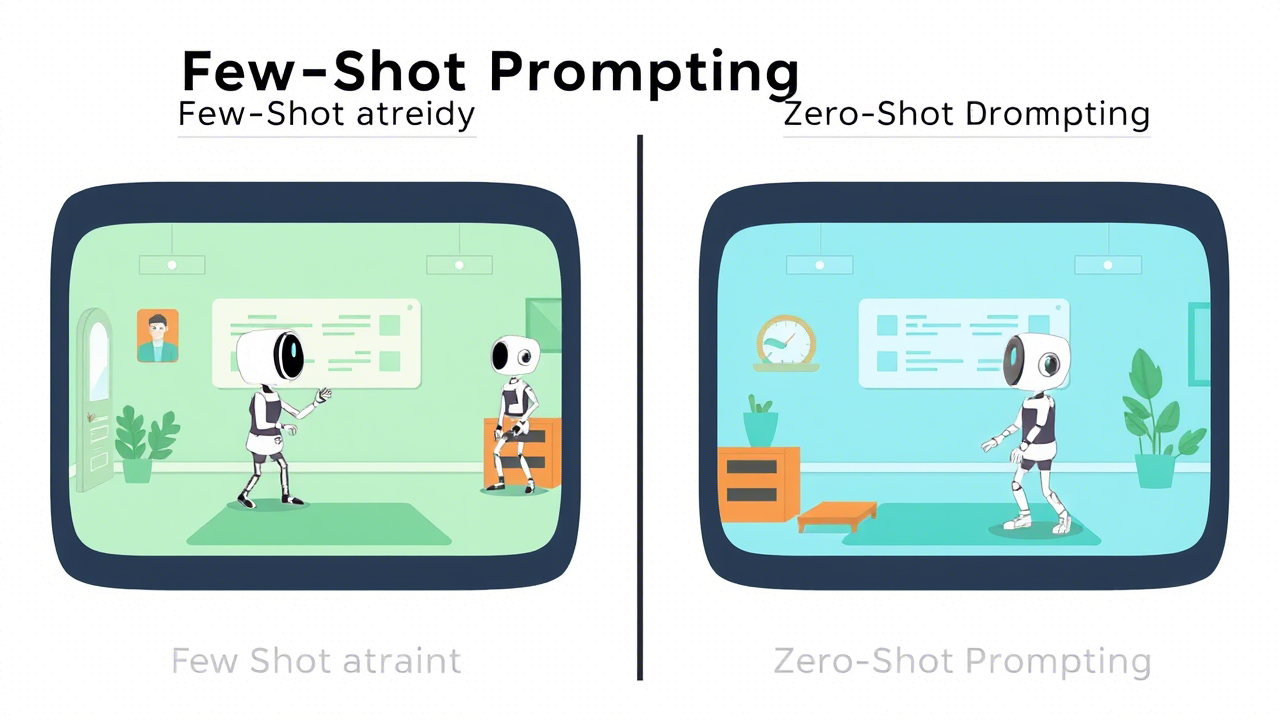

Contrairement à la suggestion par quelques exemples (Few-Shot Prompting), la suggestion zéro-exemple (Zero-Shot Prompting) n'utilise aucun exemple. Il existe plusieurs techniques zéro-exemple bien connues, utilisées soit seules, soit combinées avec un autre concept (par exemple, Chain of Thought), que nous discutons plus tard

Suggestion par Rôle

Wang et al. (2023j); Zheng et al. (2023d), également appelée suggestion par personnage (persona prompting) Schmidt et al. (2023); Wang et al. (2023l), attribue un rôle spécifique à l'IA générative dans la suggestion. Par exemple, l'utilisateur pourrait demander à l'IA d'agir comme "Madonna" ou un "écrivain de voyage". Cela peut produire des résultats plus satisfaisants pour les tâches ouvertes Reynolds et McDonell (2021) et, dans certains cas, améliorer la précision sur les benchmarks Zheng et al. (2023d).

Suggestion par Style

Lu et al. (2023a) consiste à spécifier le style, le ton ou le genre souhaité dans la suggestion afin de façonner la sortie d'une IA générative. Un effet similaire peut être obtenu en utilisant la suggestion par rôle.

Suggestion par Émotion

Li et al. (2023a) intègre des phrases ayant une pertinence psychologique pour les humains (par exemple, "Ceci est important pour ma carrière") dans la suggestion, ce qui peut améliorer les performances des LLMs sur les benchmarks et la génération de texte ouverte.

Attention Système 2 (S2A)

Weston et Sukhbaatar (2023) demande d'abord à un LLM de réécrire la suggestion et d'éliminer toute information non liée à la question posée. Ensuite, cette nouvelle suggestion est transmise à un LLM pour obtenir une réponse finale.

SimToM

Wilf et al. (2023) traite des questions complexes impliquant plusieurs personnes ou objets. Étant donné la question, il tente d'établir l'ensemble des faits qu'une personne connaît, puis répond à la question en se basant uniquement sur ces faits. C'est un processus en deux étapes qui peut aider à éliminer l'effet des informations non pertinentes dans la suggestion.

Réénoncer et Répondre (RaR)

Deng et al. (2023) instruit le LLM à reformuler et développer la question avant de générer la réponse finale. Par exemple, il pourrait ajouter la phrase suivante à la question : "Réénoncez et développez la question, puis répondez". Cela peut être fait en une seule étape ou la nouvelle question peut être transmise séparément au LLM. RaR a démontré des améliorations sur plusieurs benchmarks.

Relire (RE2)

Xu et al. (2023) ajoute la phrase "Lisez la question à nouveau :" à la suggestion, en répétant également la question. Bien que cette technique soit simple, elle a montré des améliorations dans les benchmarks de raisonnement, surtout avec des questions complexes.

Auto-Demande (Self-Ask)

Press et al. (2022) incite les LLMs à décider d'abord s'ils doivent poser des questions de suivi pour une suggestion donnée. Si tel est le cas, le LLM génère ces questions, y répond, puis répond finalement à la question originale.