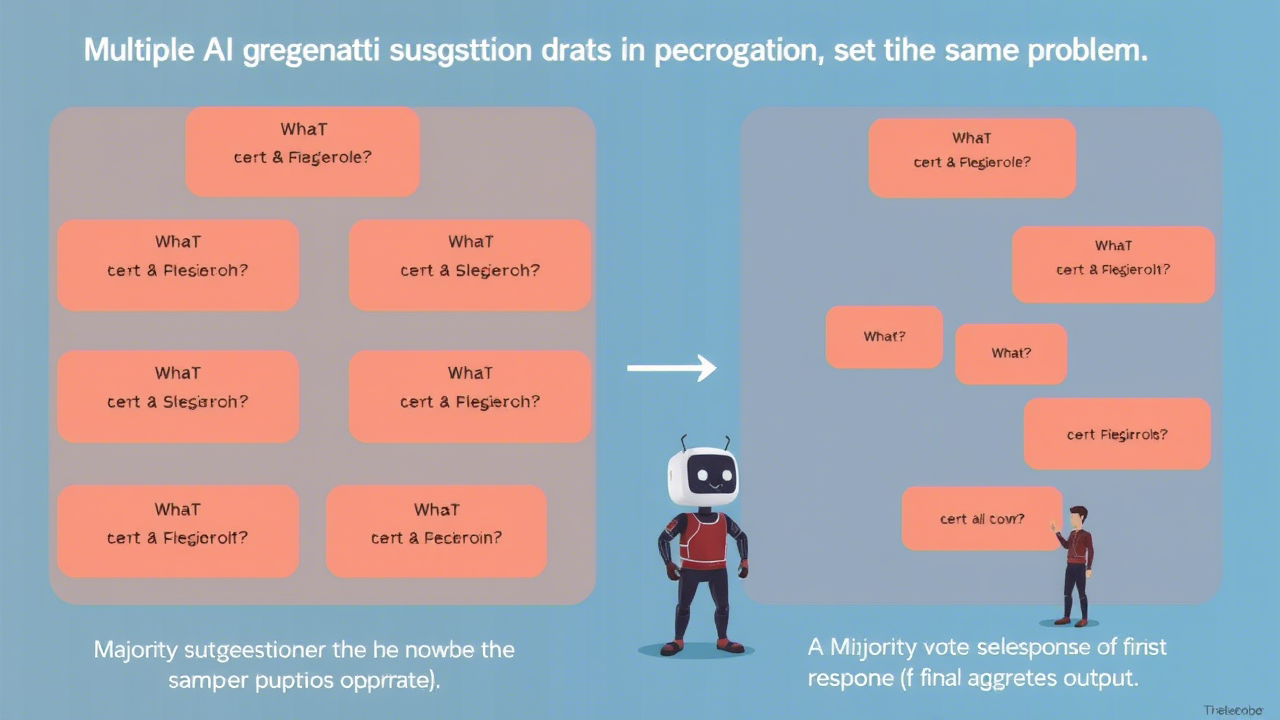

Ensemble (Regroupement)

Dans le domaine de l'IA générative, le regroupement consiste à utiliser plusieurs suggestions pour résoudre le même problème, puis à agréger ces réponses en une sortie finale. Dans de nombreux cas, un vote majoritaire – en sélectionnant la réponse la plus fréquente – est utilisé pour générer la sortie finale. Les techniques de regroupement réduisent la variance des sorties des LLMs et améliorent souvent l'exactitude, mais augmentent également le nombre d'appels au modèle nécessaires pour obtenir une réponse finale.

Regroupement par Démonstration (DENSE)

Khalifa et al. (2023) crée plusieurs suggestions Few-Shot, chacune contenant un sous-ensemble distinct d'exemples provenant du jeu d'entraînement. Ensuite, il agrège leurs sorties pour générer une réponse finale.

Mélange d'Experts en Raisonnement (MoRE)

Si et al. (2023d) crée un ensemble d'experts en raisonnement divers en utilisant différentes suggestions spécialisées pour différents types de raisonnement (par exemple, des suggestions avec augmentation de récupération pour le raisonnement factuel, des chaînes de pensée pour le raisonnement multi-étapes et mathématique, et des suggestions génératives pour le raisonnement communautaire). La meilleure réponse parmi toutes les experts est sélectionnée en fonction d'un score d'accord.

Méthode de l'Information Mutuelle Maximale

Sorensen et al. (2022) crée plusieurs modèles de suggestion avec des styles et exemples variés, puis sélectionne le modèle optimal comme celui qui maximise l'information mutuelle entre la suggestion et les sorties du LLM.

Auto-Consistance (Self-Consistency)

Wang et al. (2022) repose sur l'intuition que plusieurs chemins de raisonnement différents peuvent mener à la même réponse. Cette méthode incite d'abord le LLM à effectuer plusieurs CoT (Chaînes de Pensée), avec une température non nulle pour susciter des chemins de raisonnement diversifiés. Ensuite, elle utilise un vote majoritaire sur toutes les réponses générées pour sélectionner une réponse finale. L'auto-consistance a montré des améliorations dans les tâches arithmétiques, de raisonnement communautaire et symbolique.

Auto-Consistance Universelle

Chen et al. (2023e) est similaire à l'auto-consistance, sauf qu'au lieu de sélectionner la réponse majoritaire en comptant programmationnellement combien de fois elle apparaît, elle insère toutes les sorties dans un modèle de suggestion qui sélectionne la réponse majoritaire. Cela est utile pour la génération de texte libre et dans les cas où la même réponse peut être légèrement différente selon les suggestions.

Raisonnement Méta sur plusieurs CoTs

Yoran et al. (2023) est similaire à l'auto-consistance universelle ; il génère d'abord plusieurs chaînes de raisonnement (mais pas nécessairement des réponses finales) pour un problème donné. Ensuite, il insère toutes ces chaînes dans un seul modèle de suggestion, puis génère une réponse finale à partir d'elles.

DiVeRSe

Li et al. (2023i) crée plusieurs suggestions pour un problème donné, puis effectue l'auto-consistance pour chacune, générant ainsi plusieurs chemins de raisonnement. Ils évaluent les chemins de raisonnement en fonction de chaque étape, puis sélectionnent une réponse finale.

Auto-Adaptation Basée sur la Consistance (COSP)

Wan et al. (2023a) construit des suggestions Few-Shot CoT en exécutant Zero-Shot CoT avec auto-consistance sur un ensemble d'exemples, puis en sélectionnant un sous-ensemble des sorties ayant un fort accord pour les inclure dans la suggestion finale en tant qu'exemples. Il effectue à nouveau l'auto-consistance avec cette suggestion finale.

Auto-Adaptation Universelle (USP)

Wan et al. (2023b) s'appuie sur le succès de COSP, visant à le rendre généralisable à toutes les tâches. USP utilise des données non étiquetées pour générer des exemples et une fonction de notation plus complexe pour les sélectionner. De plus, USP n'utilise pas l'auto-consistance.

Paraphrasage de Suggestions

Jiang et al. (2020) transforme une suggestion originale en changeant certains termes tout en maintenant le sens global. C'est effectivement une technique d'augmentation de données qui peut être utilisée pour générer des suggestions pour un ensemble.

Voici un tableau récapitulatif des techniques de regroupement (ensembling) mentionnées précédemment, accompagné d'exemples pour illustrer chaque méthode :

Ce tableau offre une vue synthétique des différentes approches de regroupement, mettant en évidence leurs caractéristiques principales et fournissant des exemples concrets pour faciliter leur compréhension.